2018-2019-2 20189206 《網絡攻防實踐》 第十一週做業

2018-2019-2 20189206 《網絡攻防實踐》 第十一週做業

Burp suite

Burp Suite是Web應用程序測試的最佳工具之一,其多種功能能夠幫咱們執行各類任務,請求的攔截和修改,掃描web應用程序漏洞,以暴力破解登錄表單,執行會話令牌等多種的隨機性檢查。html

Proxy代理 ——是一個攔截HTTP/S的代理服務器,做爲一個在瀏覽器和目標應用程序之間的中間人,容許你攔截,查看,修改在兩個方向上的原始數據流。經過在默認端口8080上運行,能夠截獲並修改從客戶端到web應用程序的數據包。web

Spider蜘蛛 ——是一個應用智能感應的網絡爬蟲,它能完整的枚舉應用程序的內容和功能。Burp Suite的蜘蛛功能是用來抓取Web應用程序的連接和內容等,它會自動提交登錄表單(經過用戶自定義輸入)的狀況下,Burp Suite的蜘蛛能夠爬行掃描出網站上全部的連接,經過對這些連接的詳細掃描來發現Web應用程序的漏洞。瀏覽器

Scanner掃描器[僅限專業版] ——是一個高級的工具,執行後,它能自動地發現web應用程序的安全漏洞。可是測試過程當中會有一些誤報,並不會100%準確。安全

Intruder入侵 ——是一個定製的高度可配置的工具,對web應用程序進行自動化攻擊,如:枚舉標識符,收集有用的數據,以及使用fuzzing 技術探測常規漏洞。服務器

Repeater中繼器 ——是一個靠手動操做來補發單獨的HTTP請求,並分析應用程序響應的工具。此功能用於根據不一樣的狀況修改和發送相同的請求次數並分析。cookie

Sequencer ——是一個用來分析那些不可預知的應用程序會話令牌和重要數據項的隨機性的工具。網絡

Decoder解碼 ——是一個進行手動執行或對應用程序數據者智能解碼編碼的工具。session

Comparer ——是一個實用的工具,一般是經過一些相關的請求和響應獲得兩項數據的一個可視化的「差別」。併發

proxy代理

- 使用代理功能須要咱們可以截獲並修改請求,爲了攔截請求並對其進行操做,咱們必須經過burp suitep配置咱們的瀏覽器

在火狐瀏覽器的高級設置中,開啓代理功能ide

- 設置brup的監聽端口

- 開啓

intercept is on表示開啓攔截功能,其對應的intercept is off爲非攔截狀態,設置完代理後打開攔截狀態,瀏覽器發起的請求會被burpsuite所攔截。

- 其中

forward表示能夠繼續此次請求 drop則表示丟棄此請求數據。Action的功能是除了將當前請求的消息傳遞到Spider、Scanner、Repeater、Intruder、Sequencer、Decoder、Comparer組件外,還能夠作一些請求消息的修改,如改變GET或者POST請求方式、改變請求body的編碼,同時也能夠改變請求消息的攔截設置,如再也不攔截此主機的消息、再也不攔截此IP地址的消息、再也不攔截此種文件類型的消息、再也不攔截此目錄的消息,也能夠指定針對此消息攔截它的服務器端返回消息。

- Raw 這個視圖主要顯示web請求的raw格式,包含請求地址,http協議版本,主機頭,瀏覽器信息,accept可接受的內容類型,字符集,編碼方式,cookies等,能夠手動修改這些內容,而後在點擊forward進行滲透測試。

- params 這個視圖主要是顯示客戶端請求的參數信息,get或者post的參數,cookies參數,也均可以修改。

- headers是頭部信息和Raw其實差很少,展現更直觀。

- Hex 這個試圖顯示Raw的二進制內容。

- 咱們點擊

forward能夠看到,瀏覽器能夠正常訪問百度,關閉攔截功能,能夠在http history中看到訪問記錄

- 選擇

send to repeater能夠進入重放功能

- 選擇

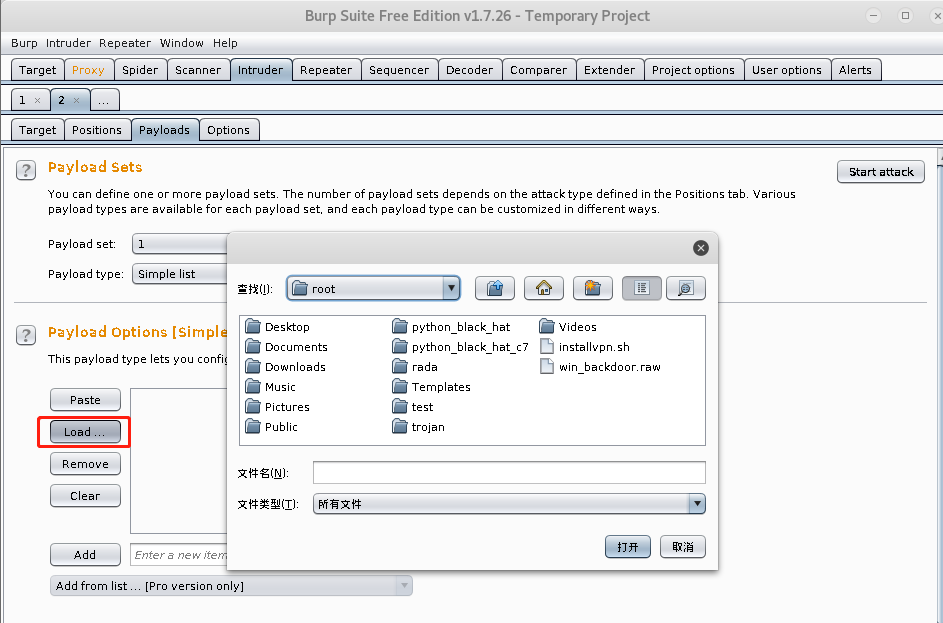

send to intruder進行爆破功能,進入後先點擊clear $把要爆破的參數後面的值選中,點擊Add $

- 設置好後進行字典的設置

Spider

- 爬網設置

其中,Maximun link depath是爬網的深度,Maximim parameterized requets per URL是指請求參數URL是多大

被動爬網:得到的連接是手動爬網時候返回頁面信息中心發現的超連接

對於爬網時遇到HTML應該如何操做

有三種操做:

- 不發送表單

- 彈出嚮導手動輸入表單後發送

- 若是下面有匹配的規則對應的表名,就自動填寫下面的值

須要表單身份認證時的操做(默認進行提示)

- 不提交表單

- 彈出嚮導手動提交表單

- 像上面普通表單同樣處理

- 自動填寫下面的表單

這裏須要設置的是線程數、失敗後從新嘗試的數目、等待時間

請求頭,在爬網時自動添加到請求頭處:

- 使用spider

一般對一個站點進行手動爬網再進行被動爬網,在Target界面對目標右鍵,選擇Spider進行爬網

scanner

我下載的community並不支持scanner功能,參考Burp Suite詳細基本用法(二):Spider、Scanner、Intruder模塊 介紹了scanner的使用方法。

Intruder

在爆破的時候會用到Intruder,右鍵點擊發送至Intruder模塊。在Proxy模塊也說起了一些,下面介紹一下攻擊類型

- 第一步 選擇攻擊類型

- sniper 只須要指定一個文件,加入該文件有兩條內容,會在第一個位置上逐一插入這兩條內容,再在第二個位置上逐一插入這兩條內容

- Battering ram 在第一二個位置上全放payload的第一個值,第二次都放第二個值

- Pitchfork 不能只指定一個字典,會在第一個字典中取第一項放在第一個位置,同時在第二個字典中取第一項放在第二個位置,以後換各自字典第二項同時替換

- Cluster bomb 不是一對一的關係,第二項裏面先用其字典的第一個值和第一項的全部字典都對應一次,以後第二項再換成字典中的第二個

- 第二步 選擇要使用的payload

介紹幾個經常使用的payload類型:

- Runtime file 用文件,只有當啓動了Intruder後文件內容才被load進去

- Case modification 會對payload每一個單詞大小進行替換

- Character block先插入100個A,下次插入150個A,最大1000個A

Username generator username生成器,根據用戶進行變形,進行猜想密碼等

- payload processing 對payload進行加工,例如添加前綴、添加後綴等

- payload Encoding 能夠對所指出的字符進行URL編碼

- 第三步 Start sttack

- 第四步 判斷

經過相應內容長度、或者狀態碼判斷是否成功,或經過關鍵字進行過濾。

也能夠經過Grep-Match,進行制定特徵字符,若是Match一個特徵字符就說明破解成功

Decoder

經過有請求的任意模塊的右鍵菜單send to Decoder或輸入數據選擇相應的數據格式便可進行解碼編碼操做。

其中Smart decode按鈕爲智能解碼,brup會遞歸查詢本身所支持的格式嘗試解碼。

支持的編碼、解碼類型有:URL、HTML、base6四、ASCII碼、hex、octal、binary以及GZIP

上圖能夠看到對於同一個數據,能夠在decoder解碼進行屢次編碼解碼的轉換。

Repeater

對數據包右鍵能夠將請求發送到repater頁面

在repeater頁面能夠對請求手動修改,併發送,能夠看到發送和響應的信息

Sequencer

序列器模塊用於檢測參數的隨機性,例如密碼或者令牌是否可預測,以此判斷關鍵數據是否能夠被僞造。此功能須要設置代理獲取目標域名,同時關閉代理攔截功能。將須要的檢測序列的目標域名發送給sequencer模塊,序列檢測性就是得到網站提取cookie信息,而後將發送大量請求,以得出序列的健壯性。

右鍵發送到Sequencer,選擇PHPSESSID這個cookie值進行判斷,或者手動進行判斷,點擊Start live capture能使服務器不斷髮送請求生成新的PHPSESSID,收集到必定量後再進行判斷(能夠點擊Sve tokens進行保存收集到的session ID),生成到足夠量的時候能夠進行analyse:

查看結果發現session ID隨機性很好

Comparer

對於數據包可使用右鍵選擇send to comparer,選擇兩個數據包進行比較

能夠看到兩個數據包的不一樣之處

參考資料

- 1. 2018-2019-2 20189206 《網絡攻防實踐》 第九周做業

- 2. 2018-2019-2 20189206 《網絡攻防實踐》 第五週做業

- 3. 20199313 2019-2020-2 《網絡攻防實踐》第十一週做業

- 4. 20169218 2016-2017-2 《網絡攻防實踐》第十一週做業

- 5. 2017-2018-2 20179215《網絡攻防實踐》第十一週做業

- 6. 20189222 《網絡攻防實踐》 第十一週做業

- 7. 20169207 2016-2017-2 《網絡攻防實踐》 第十一週做業

- 8. 20199128 2019-2020-2 《網絡攻防實踐》第十一週做業

- 9. 20189313《網絡攻防》第十週做業

- 10. 20169218 2016-2017-2 《網絡攻防實踐》第十週做業

- 更多相關文章...

- • Thymeleaf項目實踐 - Thymeleaf 教程

- • DTD - 來自網絡的實例 - DTD 教程

- • TiDB 在摩拜單車在線數據業務的應用和實踐

- • 使用Rxjava計算圓周率

-

每一个你不满意的现在,都有一个你没有努力的曾经。

- 1. 2018-2019-2 20189206 《網絡攻防實踐》 第九周做業

- 2. 2018-2019-2 20189206 《網絡攻防實踐》 第五週做業

- 3. 20199313 2019-2020-2 《網絡攻防實踐》第十一週做業

- 4. 20169218 2016-2017-2 《網絡攻防實踐》第十一週做業

- 5. 2017-2018-2 20179215《網絡攻防實踐》第十一週做業

- 6. 20189222 《網絡攻防實踐》 第十一週做業

- 7. 20169207 2016-2017-2 《網絡攻防實踐》 第十一週做業

- 8. 20199128 2019-2020-2 《網絡攻防實踐》第十一週做業

- 9. 20189313《網絡攻防》第十週做業

- 10. 20169218 2016-2017-2 《網絡攻防實踐》第十週做業