Consul集羣版容器化部署與應用集成

背景

因爲公司目前的主要產品使用的註冊中心是consul,consul須要用集羣來保證高可用,傳統的方式(Nginx/HAProxy)會有單點故障問題,爲了解決該問題,我開始研究如何只依賴consul作集羣的註冊的方式,通過一天的折騰,總算驗證了能夠經過集羣版ConsulClient來進行集羣註冊,在部署實施過程當中也遇到了一些問題,特此記錄分享,但願能對有須要的同窗有幫助。node

主機版集羣和docker版集羣對比

client+server轉發模式的集羣部署涉及到兩種選擇,第一種是直接主機模式部署,2個client+3個server,每一個consul實例部署一臺主機(適合土豪使用),此種模式的好處就是簡單暴力,並且運維相對簡單。此種模式的架構部署圖以下: git

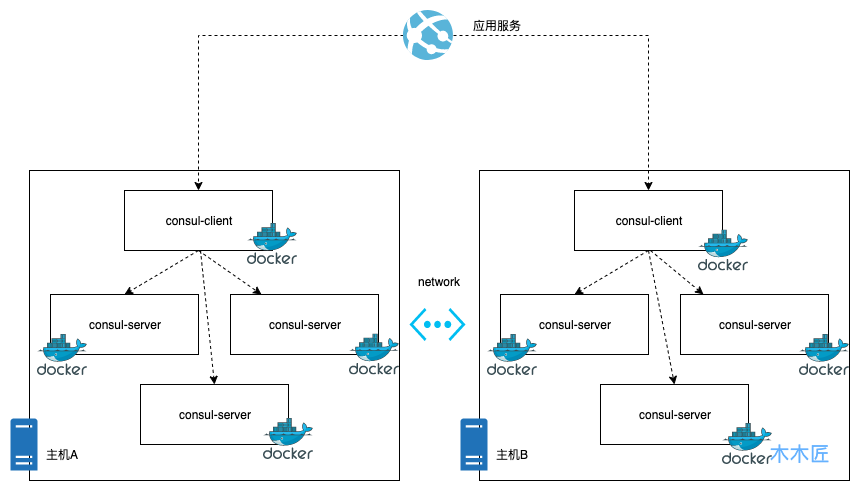

咱們選擇的是另一種經濟節約模式,docker化部署,好處就是節約資源,劣勢就是要管理許多docker鏡像,在有引入k8s這些容器管理平臺以前,後續docker的運維會比較麻煩,這種模式的架構部署圖以下:github

經過以上兩種模式的架構圖咱們很清楚的就能知道主機部署模式是最簡單直接的,而docker的模式雖然節省了資源,可是加大了複雜性,增長了運維的難度。可是這種模式應該是在目前容器化的環境下很好的選擇,緣由很簡單,由於充分的利用了資源,容器的運維能夠交給容器運維平臺去完成,好比k8s等。下面咱們來實踐下如何進行容器化的consul集羣部署。web

環境準備

這裏準備了兩臺虛擬主機,因爲是虛擬的主機,對外ip是同樣的,因此咱們以端口區分。spring

主機A:192.168.23.222:10385 內網ip:192.168.236.3

主機B:192.168.23.222:10585 內網ip:192.168.236.5

複製代碼

部署配置

步驟一:主機安裝Docker環境(以Centos爲例)docker

yum install docker

複製代碼

步驟二:拉取Consul鏡像進行部署shell

docker pull consul

複製代碼

步驟三:給主機Docker分配ip段,防止多主機ip重複json

- 在主機A編輯

docker的/etc/docker/daemon.json文件,添加下面的內容

"bip": "172.17.1.252/24"

複製代碼

- 在主機B編輯

docker的/etc/docker/daemon.json文件,添加下面的內容

"bip": "172.17.2.252/24"

複製代碼

這裏的配置是給主機的docker實例分配ip,由於後續docker會進行跨主機註冊,若是默認註冊的話,docker是用的主機內網,從而致使ip重複,因此這裏手動進行ip分配,固然上述的ip配置你能夠自定義。bootstrap

步驟四:在主機A部署Consulbash

Node1:

docker run -d --name=node_31 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 11300:8300 \

-p 11301:8301 \

-p 11301:8301/udp \

-p 11302:8302/udp \

-p 11302:8302 \

-p 11400:8400 \

-p 11500:8500 \

-p 11600:8600 \

consul agent -server -join=172.17.1.1 -bootstrap-expect=3 -node=node31 \

-data-dir=/consul/data/ -client 0.0.0.0 -ui

複製代碼

這裏重點說明幾個參數:

--name:是docker容器的名字,每一個容器實例不同

-node:是consul節點的名字,每一個節點不同

-bootstrap-expect:是啓動集羣指望至少多少個節點,這裏設置是3個。

-data-dir:是consul的數據中心的目錄,必須給與consul讀寫權限,不然啓動會報錯。

啓動成功後,執行命令查看consul的節點。

docker exec -t node_31 consul members

複製代碼

顯示結果以下:

Node Address Status Type Build Protocol DC Segment

node31 172.17.1.1:8301 alive server 1.6.2 2 dc1 <all>

複製代碼

這說明第一個節點正常啓動了,接下來正常啓動主機A剩下的節點。

Node2:

docker run -d --name=node_32 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 9300:8300 \

-p 9301:8301 \

-p 9301:8301/udp \

-p 9302:8302/udp \

-p 9302:8302 \

-p 9400:8400 \

-p 9500:8500 \

-p 9600:8600 \

consul agent -server -join=172.17.1.1 -bootstrap-expect=3 -node=node32 \

-data-dir=/consul/data/ -client 0.0.0.0 -ui

複製代碼

Node3:

docker run -d --name=node_33 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 10300:8300 \

-p 10301:8301 \

-p 10301:8301/udp \

-p 10302:8302/udp \

-p 10302:8302 \

-p 10400:8400 \

-p 10500:8500 \

-p 10600:8600 \

consul agent -server -join=172.17.1.1 -bootstrap-expect=3 -node=node33 \

-data-dir=/consul/data/ -client 0.0.0.0 -ui

複製代碼

三個節點啓動完畢後,執行命令,查看節點的狀態:

docker exec -t node_31 consul operator raft list-peers

複製代碼

結果以下:

Node ID Address State Voter RaftProtocol

node32 ee186aef-5f8a-976b-2a33-b20bf79e7da9 172.17.1.2:8300 follower true 3

node33 d86b6b92-19e6-bb00-9437-f988b6dac4b2 172.17.1.3:8300 follower true 3

node31 0ab60093-bed5-be77-f551-6051da7fe790 172.17.1.1:8300 leader true 3

複製代碼

這裏已經顯示,三個server的節點已經完成了集羣部署,而且選舉了node_31做爲主節點。最後給該主機集羣部署一個client就大功告成了。

Node4(client節點)

docker run -d --name=node_34 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"leave_on_terminate": true}' \

-p 8300:8300 \

-p 8301:8301 \

-p 8301:8301/udp \

-p 8302:8302/udp \

-p 8302:8302 \

-p 8400:8400 \

-p 8500:8500 \

-p 8600:8600 \

consul agent -retry-join=172.17.1.1 \

-node-id=$(uuidgen | awk '{print tolower($0)}') \

-node=node34 -client 0.0.0.0 -ui

複製代碼

執行docker exec -t node_31 consul members命令,結果以下:

Node Address Status Type Build Protocol DC Segment

node31 172.17.1.1:8301 alive server 1.6.2 2 dc1 <all>

node32 172.17.1.2:8301 alive server 1.6.2 2 dc1 <all>

node33 172.17.1.3:8301 alive server 1.6.2 2 dc1 <all>

node34 172.17.1.4:8301 alive client 1.6.2 2 dc1 <default>

複製代碼

這裏說明,主機A的consul節點所有啓動完成,而且完成了集羣部署,能夠說這就是一個單主機版的consul集羣,那麼接下來咱們要作的就是把主機B的consul加入到主機A的集羣中便可。

步驟五:在主機B部署Consul

Node5

docker run -d --name=node_51 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 11300:8300 \

-p 11301:8301 \

-p 11301:8301/udp \

-p 11302:8302/udp \

-p 11302:8302 \

-p 11400:8400 \

-p 11500:8500 \

-p 11600:8600 \

consul agent -server -join=172.17.1.1 -bootstrap-expect=3 -node=node_51 \

-data-dir=/consul/data/ -client 0.0.0.0 -ui

複製代碼

Node6

docker run -d --name=node_52 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 9300:8300 \

-p 9301:8301 \

-p 9301:8301/udp \

-p 9302:8302/udp \

-p 9302:8302 \

-p 9400:8400 \

-p 9500:8500 \

-p 9600:8600 \

consul agent -server -join=172.17.1.1 -bootstrap-expect=3 -node=node_52 \

-data-dir=/consul/data/ -client 0.0.0.0 -ui

複製代碼

Node7

docker run -d --name=node_53 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"skip_leave_on_interrupt": true}' \

-p 10300:8300 \

-p 10301:8301 \

-p 10301:8301/udp \

-p 10302:8302/udp \

-p 10302:8302 \

-p 10400:8400 \

-p 10500:8500 \

-p 10600:8600 \

consul agent -server -join=172.17.1.1 -bootstrap-expect=3 -node=node_53 \

-data-dir=/consul/data/ -client 0.0.0.0 -ui

複製代碼

主機B的三個server節點部署完成後,咱們執行命令docker exec -t node_51 consul members查看下集羣節點狀態

Node Address Status Type Build Protocol DC Segment

node_51 172.17.2.1:8301 alive server 1.6.2 2 dc1 <all>

複製代碼

爲何只有node_51這個單獨的節點呢?是否是節點的問題?咱們在主機B中查詢一樣查詢一下,結果以下:

node31 172.17.1.1:8301 alive server 1.6.2 2 dc1 <all>

node32 172.17.1.2:8301 alive server 1.6.2 2 dc1 <all>

node33 172.17.1.3:8301 alive server 1.6.2 2 dc1 <all>

node34 172.17.1.4:8301 alive client 1.6.2 2 dc1 <default>

複製代碼

主機A的節點只有他們本身機器的節點,主機B中的節點所有未註冊過來,這是爲何呢?緣由就是consul綁定的ip是容器的內網ip,主機內部通信是能夠的,跨主機通信是沒法經過內網地址進行通信的,那麼咱們怎麼作呢?咱們經過路由規則進行轉發便可,把主機A請求主機B容器的內網地址轉發到主機B便可,這裏就體現出咱們開始給容器分配ip的做用了。 咱們在主機A執行以下命令:

route add -net 172.17.2.0 netmask 255.255.255.0 gw 192.168.236.5

複製代碼

這條命令的意思是,添加一個路由規則172.17.2.1~172.17.2.254範圍的ip請求,所有轉發到192.168.236.5地址下,也就是咱們的主機B。 同理主機B也執行以下命令:

route add -net 172.17.1.0 netmask 255.255.255.0 gw 192.168.236.3

複製代碼

添加完成後,在執行docker exec -t node_53 consul members命令:

Node Address Status Type Build Protocol DC Segment

node31 172.17.1.1:8301 alive server 1.6.2 2 dc1 <all>

node32 172.17.1.2:8301 alive server 1.6.2 2 dc1 <all>

node33 172.17.1.3:8301 alive server 1.6.2 2 dc1 <all>

node_51 172.17.2.1:8301 alive server 1.6.2 2 dc1 <all>

node_52 172.17.2.2:8301 alive server 1.6.2 2 dc1 <all>

node_53 172.17.2.3:8301 alive server 1.6.2 2 dc1 <all>

node34 172.17.1.4:8301 alive client 1.6.2 2 dc1 <default>

複製代碼

集羣加入就成功了,這就完成了跨主機的docker容器加入。 最後給主機B部署一個client

Node8(client節點)

docker run -d --name=node_54 --restart=always \

-e 'CONSUL_LOCAL_CONFIG={"leave_on_terminate": true}' \

-p 8300:8300 \

-p 8301:8301 \

-p 8301:8301/udp \

-p 8302:8302/udp \

-p 8302:8302 \

-p 8400:8400 \

-p 8500:8500 \

-p 8600:8600 \

consul agent -retry-join=172.17.1.1 \

-node-id=$(uuidgen | awk '{print tolower($0)}') \

-node=node54 -client 0.0.0.0 -ui

複製代碼

最後的集羣節點所有加入成功了,結果以下:

node31 172.17.1.1:8301 alive server 1.6.2 2 dc1 <all>

node32 172.17.1.2:8301 alive server 1.6.2 2 dc1 <all>

node33 172.17.1.3:8301 alive server 1.6.2 2 dc1 <all>

node_51 172.17.2.1:8301 alive server 1.6.2 2 dc1 <all>

node_52 172.17.2.2:8301 alive server 1.6.2 2 dc1 <all>

node_53 172.17.2.3:8301 alive server 1.6.2 2 dc1 <all>

node34 172.17.1.4:8301 alive client 1.6.2 2 dc1 <default>

node54 172.17.2.4:8301 alive client 1.6.2 2 dc1 <default>

複製代碼

執行節點狀態命令docker exec -t node_31 consul operator raft list-peers:

node32 ee186aef-5f8a-976b-2a33-b20bf79e7da9 172.17.1.2:8300 follower true 3

node33 d86b6b92-19e6-bb00-9437-f988b6dac4b2 172.17.1.3:8300 follower true 3

node31 0ab60093-bed5-be77-f551-6051da7fe790 172.17.1.1:8300 leader true 3

node_51 cfac3b67-fb47-8726-fa31-158516467792 172.17.2.1:8300 follower true 3

node_53 31679abe-923f-0eb7-9709-1ed09980ca9d 172.17.2.3:8300 follower true 3

node_52 207eeb6d-57f2-c65f-0be6-079c402f6afe 172.17.2.2:8300 follower true 3

複製代碼

這樣一個包含6個server+2個client的consul容器化集羣就部署完成了,咱們查看consul的web面板以下:

應用集成

集羣版本的consul咱們就部署好了,那麼咱們如何與應用集成呢?咱們只要集成集羣版本的consul註冊客戶端就好了。 首先加入依賴

<dependency>

<groupId>com.github.penggle</groupId>

<artifactId>spring-cloud-starter-consul-cluster</artifactId>

<version>2.1.0.RELEASE</version>

</dependency>

複製代碼

第二步在bootstrap.yml|properties中指定spring.cloud.consul.host爲多節點,以下所示:

spring.cloud.consul.host=192.168.23.222:10385,192.168.23.222:10585

複製代碼

若是想輸出註冊的相關日誌的話也能夠在logback上加上日誌配置

<logger name="org.springframework.cloud.consul" level="TRACE"/>

複製代碼

這樣配置完成後啓動成功就能看到咱們的應用註冊成功了,下圖是我測試的註冊成功的效果:

這裏顯示個人應用節點分別都註冊到了集羣的2個client上面,經過client的代理轉發請求到健康的server,從而實現了consul的高可用。

總結

這篇文章沒有研究什麼技術乾貨,純粹是工做經驗分享,主要講了consul集羣部署的方式,傳統模式能夠經過HAProxy來完成集羣的部署,可是這種方式的弊端很明顯,經過虛擬ip仍是可能會指向故障的節點,因此咱們用consul的client+server模式的集羣部署,經過docker化來充分利用了機器的資源,只須要2臺機器就能完成集羣的高可用效果。

- 1. Docker 容器部署 Consul 集羣

- 2. Consul集羣部署

- 3. Centos7.4 consul集羣部署

- 4. Docker部署Consul集羣

- 5. kubernetes容器集羣部署Etcd集羣

- 6. Ceph集羣Docker容器化部署

- 7. 【Flink】Flink集羣部署與YARN集成

- 8. Consul集羣部署模式server+client

- 9. Consul 集羣部署 + ACL 配置

- 10. Linux----CEPH集羣部署與擴容

- 更多相關文章...

- • Swarm 集羣管理 - Docker教程

- • Maven 自動化部署 - Maven教程

- • Docker容器實戰(六) - 容器的隔離與限制

- • 使用阿里雲OSS+CDN部署前端頁面與加速靜態資源

-

每一个你不满意的现在,都有一个你没有努力的曾经。